2. 重庆大学 自动化学院, 重庆 400044

2. College of Automation, Chongqing University, Chongqing 400044, P. R. China

随着社会经济的快速增长与生产力的不断提升,人民生活水平得到了显著改善,在出行方面早已步入机动化时代,机动车的数量也随之日益增多。据相关统计资料显示,截至2013年底,中国的机动车数量已达到了2.5亿多辆[1]。车辆数量的大幅增长,给人们生活带来诸多便利的同时,也相继引发了一系列交通问题。道路拥堵严重困扰着高速发展的城市化进程,交通事故的频发也严重威胁着人们的生命安全。据统计,有超过半数的交通事故发生在车辆出现异常行驶行为的10 min内[2]。如果能及时检测和发现道路中车辆的异常行驶行为,通过有效的措施处理消除异常行为,并将异常行为的相关信息告知后来车辆,就能有效地减少和避免交通事故的发生。因此及时有效地检测出车辆异常行为对减小交通事故发生率,挽救生命和财产损失,提高交通安全性具有重大意义。

传统的车辆行为检测主要依赖于人工手段,如车辆巡逻、目击者举报或者人为观看监控视频。这些方法简单直接,但需要占用大量的时间和人力。在传感器技术不断发展的基础上,地感线圈也广泛应用于交通监管检测中[3]。其在检测效率上有一定的提高,检测性能稳定,抗干扰能力强,但线圈在安装和维护时需封闭道路,中断交通,路面容易遭到破坏。随着通信技术、计算机视觉技术、图像处理技术、计算机软件技术的发展以及硬件性能的提高,交通视频检测技术得到了高速的发展[4]。基于视频的车辆异常行为检测技术能在无人工干预的情况下实现车辆行为的自动检测,且能获取丰富的交通信息,安装和检测不需要破坏路面交通,维护费用低。因此视频检测是未来车辆异常行为检测的发展和应用方向,它所提供的丰富数据是实现交通智能化管理和控制的有效保证[5]。基于采用智能视频技术进行车辆异常行为检测的优越性,产生了一系列基于视频的车辆异常行为检测方法。其中,Kimachi等[6]人采用图像序列分析技术,对于可能导致交通事故的车辆异常行为,从图像序列中提取出这些行为的特征,并结合模糊理论估计出车辆行驶状态。叶容炬等[7]人在视频处理的基础上,得到各个车道上的车辆行驶时空图,根据时间序列上车辆位置的变化检测车辆的异常行为。庞成俊[8]利用全方位视觉传感器获得交叉路口的场景信息,并对全景图像进行透视展开,通过比较由跟踪所得的车辆轨迹与数据库中的车辆轨迹,判断车辆的行驶状态是否正常。彭银香等[9]人采用数字图像处理技术,通过跟踪车辆提取出车辆的运动信息,并结合隐马尔科夫模型判断车辆异常行为发生的概率。拜佩等[10]运用视频处理技术,预测出2个目标在下一帧图像中的具体参数,判断2个目标是否有重合区域达到检测碰撞这一异常行为的目的。

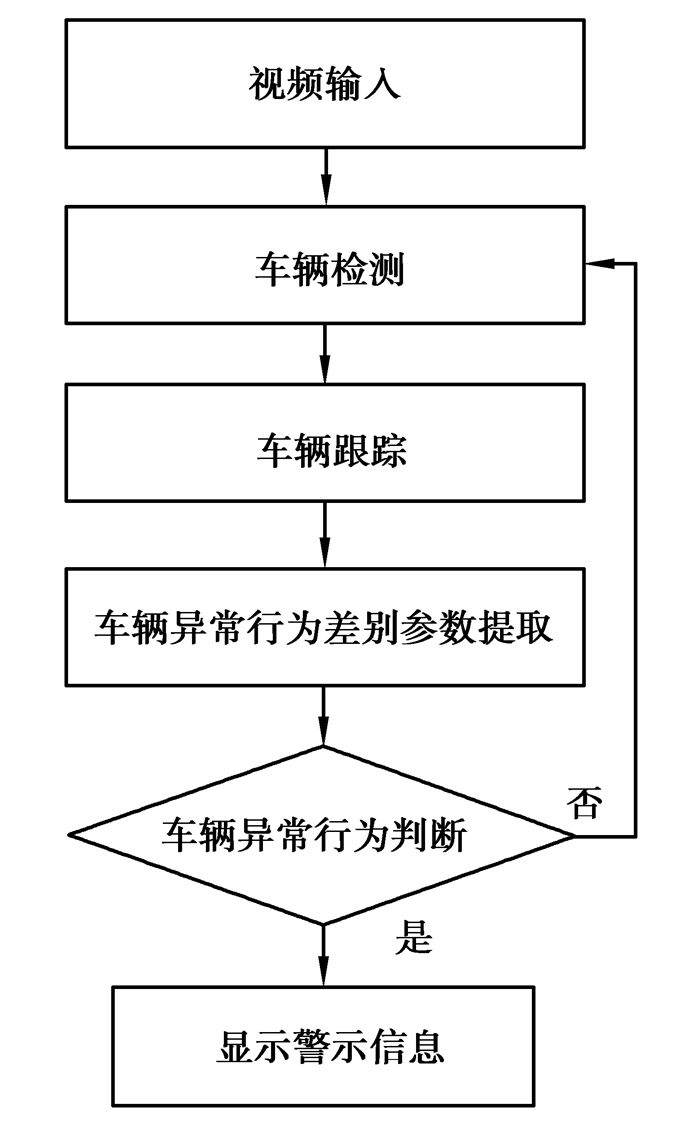

随着视频检测技术的发展日趋成熟,性能不断提高,视频检测技术在交通监控领域的推广具有广阔的应用前景。通过对大量道路车辆视频分析发现,车辆出现异常行为时车辆位置变化、速度变化及运动方向变化较大[11]。因此提出一种基于智能视频分析的车辆异常行为检测方法。运用背景差分法从交通视频中检测出运动车辆,结合二值化、形态学处理等方法对检测到的车辆进行后续处理。采用均值漂移算法跟踪运动车辆,在跟踪的基础上获取车辆位置、车辆速度、车辆运动方向等车辆异常行为判别参数。通过对3种判别参数的状态函数进行加权融合,实现对车辆行为的实时检测,并以警示信息的形式提示有异常行为发生。其算法流程图如图 1所示。

|

图1 车辆异常行为检测算法流程图 Fig. 1 Flow chart of vehicle abnormal behavior detection algorithm |

基于智能视频分析的车辆异常行为检测方法可分为车辆检测、车辆跟踪、车辆异常行为判别参数提取及车辆行为判别等具体部分。

1.1 车辆检测采用智能视频分析技术检测车辆异常行为,首先需要实时有效地检测出运动车辆。运动车辆检测即通过运用视频图像分析技术,在实时监控视频中提取出运动车辆的过程。该过程属于运动目标检测的范畴。运动目标检测是视频分析处理的基础,目前帧差法、光流法以及背景差分法是3种运用较为广泛的目标检测方法[12]。采用背景差分法检测运动目标,获取的特征数据比较完整,同时计算复杂度较低,因此具有较大的实用价值[13]。背景差分法即将当前图像与背景图像相减,将差值与所设置的阈值进行比较,若差值大于设定的阈值,则将该点视为目标点,反之该点即为背景点。背景差分法的计算公式如下

| ${D_k}\left( {x,y} \right) = \left| {{I_k}\left( {x,y} \right) - {B_k}\left( {x,y} \right)} \right|$ | (1) |

式中:Dk(x,y)表示差值图像,Ik(x,y)表示当前图像,Bk(x,y)表示背景图像。

在运用背景差分法之前,首先需要获取背景图像,并保证背景图像的实时性。在道路交通中,虽然各种场景并不简单,但显示背景的可能性仍然较高,用统计学的观点分析来看,在这段较长的时间范围内,由运动物体经过引起的背景灰度值变化可以通过平均的思想来消除[14]。利用多帧图像平均法初始化背景图像,并通过对已有背景和当前图像进行迭代,实现背景的实时更新,使得提取的背景图像尽量接近于实际值。

其具体方法为

1)对视频图像序列中的前帧图像运用多帧图像平均法得到初始化的背景图像,其计算公式如下

| ${B_n}\left( {x,y} \right) = \frac{1}{n}\sum\limits_{i = 1}^n {{I_i}} \left( {x,y} \right)$ | (2) |

式中:Ii(x,y)表示第帧图像的像素值,n为初始化背景图像时进行平均的总帧数。

2)从第n+1帧图像开始,进行背景更新。具体更新方法是将当前图像与已获取的背景图像Bn(x,y)进行迭代累积,得到第n+1帧图像的背景图像Bn+1(x,y)。计算公式如下

| ${B_{n + 1}}\left( {x,y} \right) = \left( {1 - \alpha } \right){B_n}\left( {x,y} \right) + \alpha {I_{n + 1}}\left( {x,y} \right)$ | (3) |

式中:In+1(x,y)表示第n+1帧图像的像素值。常数α表示背景更新的速率,0<α<1。迭代系数α的取值比较关键,取值太小背景更新慢,对天气和光照的变化不敏感,取值太大则会影响背景差分的效果。

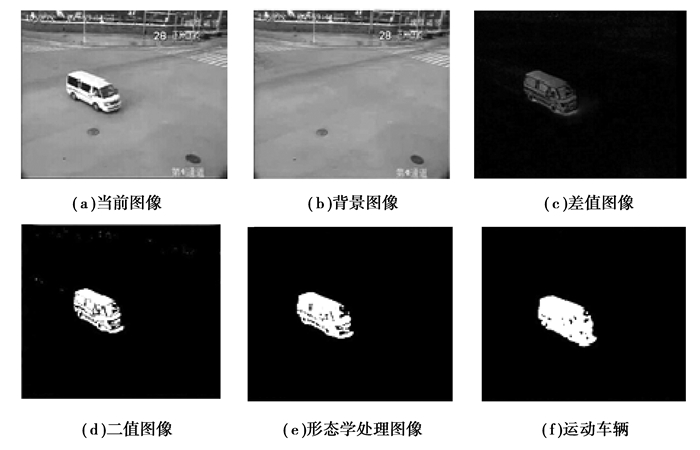

采用背景差分法得到差值图像后,对差值图像进行二值化处理,使车辆与背景呈现出黑白的对比效果,同时结合形态学处理过程,消除小的空洞,填补轮廓线中的断裂,使车辆轮廓变光滑,得到的车辆检测图如图 2所示。

|

图2 车辆检测效果图 Fig. 2 The result of vehicle detection |

车辆跟踪即将当前帧中检测到的运动车辆与上一帧图像中的车辆进行匹配的过程[15]。均值漂移算法是近几年较为流行的跟踪算法。该算法是一种非参数的概率密度估计方法,通过迭代寻优找到概率分布的极值来定位目标。均值漂移算法的算法步骤可划分为如下

1)初始化搜索窗口的位置和大小。

2)在搜索窗口中计算二值图像的零阶矩M00、一阶矩M01及质心(xc,yc)。相应的计算公式可表示如下

| ${M_{00}} = \sum\limits_x {\sum\limits_y {I\left( {x,y} \right)} }$ | (4) |

| ${M_{01}} = \sum\limits_x {\sum\limits_y {xI\left( {x,y} \right)} } $ | (5) |

| ${M_{10}} = \sum\limits_x {\sum\limits_y {yI\left( {x,y} \right)} } $ | (6) |

| ${x_c} = {M_{01}}/{M_{00}}$ | (7) |

| ${y_c} = {M_{10}}/{M_{00}}$ | (8) |

式中:I(x,y)表示二值图像在(x,y)处的像素值。

3)调整搜索窗口的大小。

4)将搜索窗口的中心移动到质心处,在此过程中,如果移动的距离大于预先设定的阈值,则重复3)和4),直到搜索窗口的中心移动到质心的距离小于阈值,或者循环的次数达到设定的最大值,则停止计算。

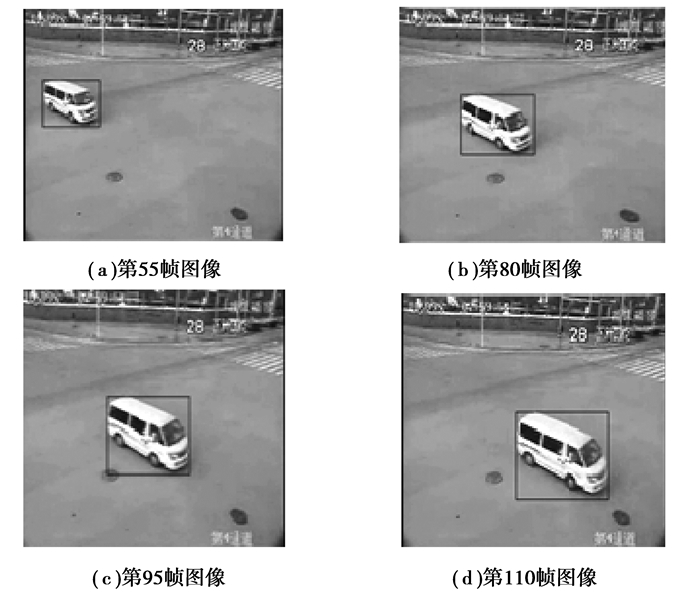

针对视频的所有图像帧按上述步骤进行计算,并将上一帧的计算得到的搜索窗的大小和中心,作为当前帧搜索窗的初始值,就可以实现对目标的跟踪。在均值漂移算法中,跟踪目标由目标的外接矩形表示。跟踪效果如图 3所示。

|

图3 车辆跟踪效果图 Fig. 3 The result of vehicle tracking |

通过车辆检测和车辆跟踪,可以得到当前监控视频中是否有运动车辆以及运动车辆的运动信息。进一步分析相关的运动信息,可以得到车辆位置、车辆速度、运动方向变化等车辆异常行为判别参数。

在运动车辆跟踪过程中外接矩形提取的基础上,以跟踪到的车辆外接矩形的中心点来表示车辆的位置。用车辆外接矩形的中心点代表车辆的实际位置,可避免像素遍历和复杂计算。车辆位置的较大幅度改变是车辆出现异常行为的典型特征,位置改变量的大小用像素来衡量。车辆位置的改变量可计算如下

| $p = \sqrt {{{\left( {{x_n} - {x_{n - 1}}} \right)}^2} + {{\left( {{y_n} - {y_{n - 1}}} \right)}^2}} $ | (9) |

式中:(xn,yn)表示当前图像帧中车辆的外接矩形的中心点,(xn-1,yn-1)表示上一帧图像中车辆外接矩形的中心点。

车辆速度的改变可用车辆加速度表示,令a表示车辆加速度值,则车辆速度的改变量可计算如下

| $a = \frac{{{v_f} - {v_i}}}{{{t_f} - {t_i}}}$ | (10) |

式中:vf及vi分别表示tf及ti时刻的速度值。

车辆运动方向的改变与车辆位置有关。同理可用车辆外接矩形的中心(xn,yn)及(xn-1,yn-1)分别表示当前帧与上一帧车辆的位置。车辆的运动方向变化值可简单表示如下

| $\theta = \arctan \left( {\left| {\frac{{{y_n} - {y_{n - 1}}}}{{{x_n} - {x_{n - 1}}}}} \right|} \right)$ | (11) |

进一步可以得到车辆位置、车辆速度、车辆运动方向的改变量的状态函数g(p),h(a),j(θ)。当车辆位置的改变量的绝对值大于设定的位置改变量阈值Tp时,车辆位置改变量的状态函数g(p)的取值为1,反之,其取值为0。相应的Ta及Tθ分别表示车辆速度改变量的设定阈值和车辆运动方向改变量的设定阈值,h(a)及j(θ)的取值方法与g(p)类似。g(p),h(a)及j(θ)可分别计算如下

| $g\left( p \right) = \left\{ \begin{gathered} 1,\left| p \right|{\text{ > }}{T_p},\hfill \\ 0,{\text{otherwise}} \hfill \\ \end{gathered} \right.$ | (12) |

| $h\left( a \right) = \left\{ \begin{gathered} 1,\left| a \right|{\text{ > }}{T_a},\hfill \\ 0,{\text{otherwise}} \hfill \\ \end{gathered} \right.$ | (13) |

| $j\left( \theta \right) = \left\{ \begin{gathered} 1,\left| \theta \right|{\text{ > }}{T_\theta },\hfill \\ 0,{\text{otherwise}} \hfill \\ \end{gathered} \right.$ | (14) |

车辆异常行为的检测原理即获取车辆位置、车辆速度以及车辆运动方向的改变量,同时由于各参数影响因子的不同,采用对3种车辆异常行为判别参数的状态函数进行加权融合的方法,更容易实现对车辆异常行为的灵活检测。以α、β、γ分别表示车辆位置、车辆速度、车辆运动方向改变量状态函数的权重值,且满足α+β+γ=1。加权融合的结果与阈值车辆异常行为判别阈值T比较,若大于设定阈值,则表示车辆出现异常行为,反之,则视为无异常行为发生。进行车辆异常行为检测的流程图如图 4所示。

|

图4 车辆异常行为检测流程图 Fig. 4 Flow chart of vehicle abnormal behavior detection algorithm |

为验证采用算法的有效性,2段从真实交通场景采集得到的监控视频被用来作为车辆异常行为检测测试序列。检测视频1长334帧,每帧为480像素×272像素。检测视频2长155帧,每帧为为480像素×272像素。系统操作平台为windows7,内存为2.00 GB,仿真平台为Matlab 2010b。

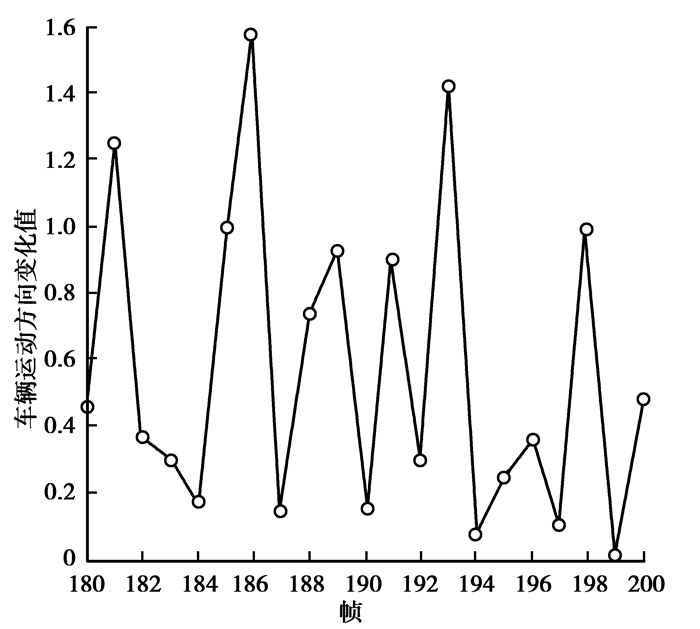

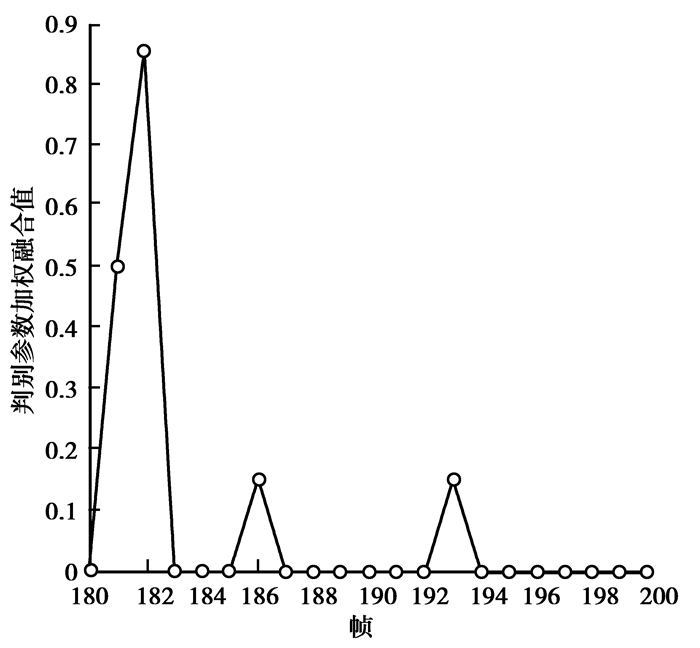

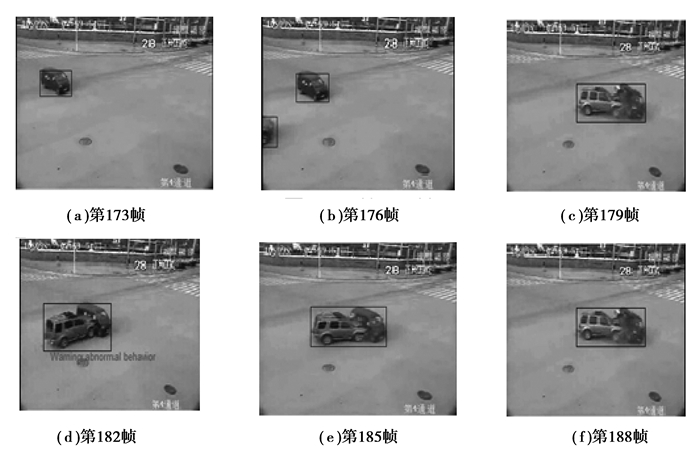

2.1 车辆碰撞检测人为观察检测视频1可知,视频中车辆2有异常行为出现:与车辆1发生碰撞事故。车辆2的车辆位置改变量、车辆速度改变量、车辆运动方向改变量结果图分别如图 5、图 6、图 7所示,经过大量实验验证,取车辆位置改变量阈值Tp=60、车辆速度改变量阈值Ta=80、车辆运动方向改变量阈值Tθ=1.2。通过反复实验分析,分别取车辆位置改变量、车辆速度改变量、车辆运动方向改变量状态函数的加权系α=0.5,β=0.35,γ=0.15,车辆异常行为判别阈值T=0.7,得到车辆行为判别参数状态函数的加权融合结果如图 8所示。实际视频场景中车辆异常行为检测结果如图 9所示。检测视频中第172帧出现车辆1,第179帧出现车辆2,在第182帧图像中检测出车辆2出现的异常行为,视频图像中出现红色警示信息。车辆1与车辆2从第183帧开始整体进行运动。

|

图5 车辆位置改变图Tp=60 Fig. 5 The change of vehicle position Tp=60 |

|

图6 车辆速度改变图Ta=80 Fig. 6 The change of vehicle velocity Ta=80 |

|

图7 车辆运动方向改变图Tθ=1.2 Fig. 7 The change of vehicle moving direction Tθ=1.2 |

|

图8 车辆异常行为判别参数状态函数加权融合结果图α=0.5,β=0.35,γ=0.15,T=0.7 Fig. 8 Weighted fusion result of vehicle abnormal behavior discrimination parameters α=0.5,β=0.35,γ=0.15,T=0.7 |

|

图9 车辆异常行为检测过程 Fig. 9 The process of vehicle abnormal behavior detection |

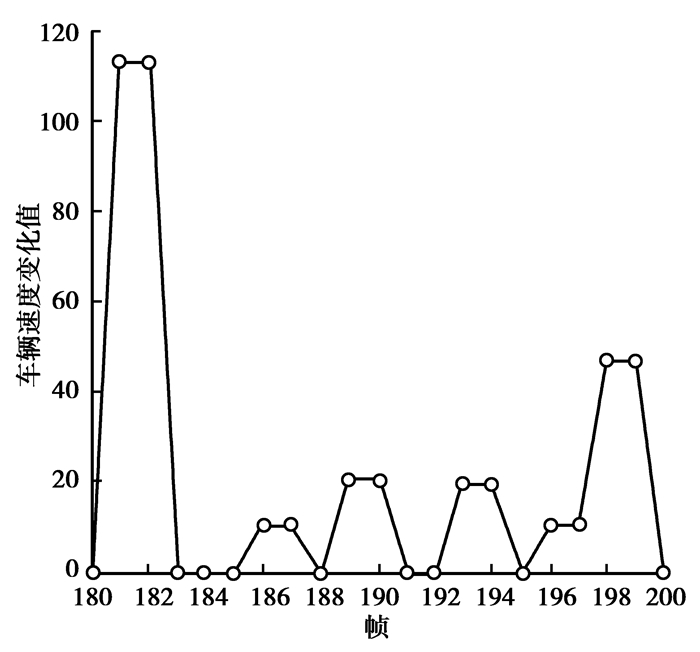

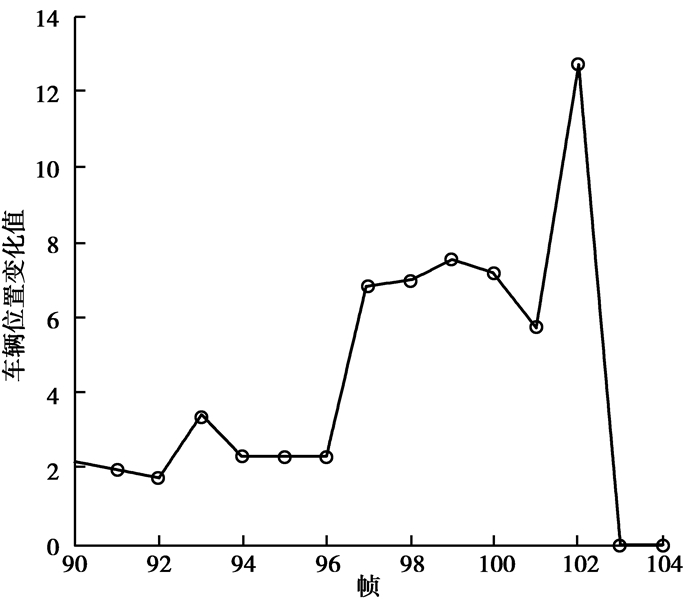

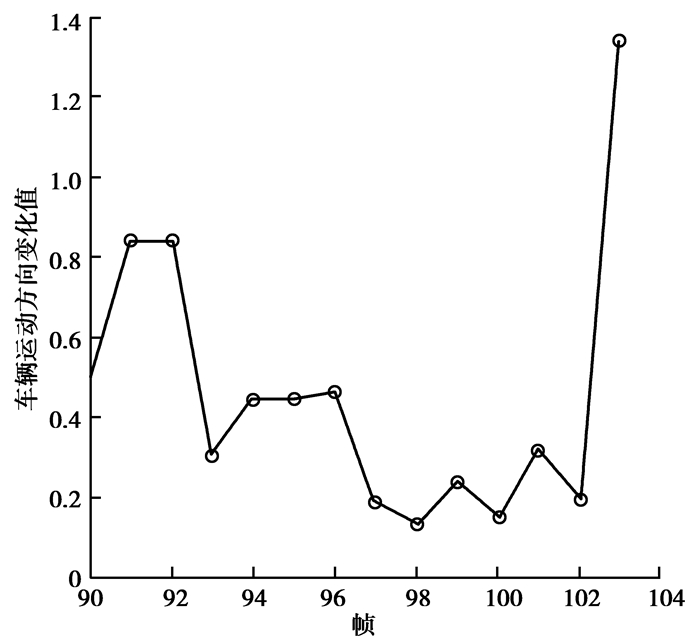

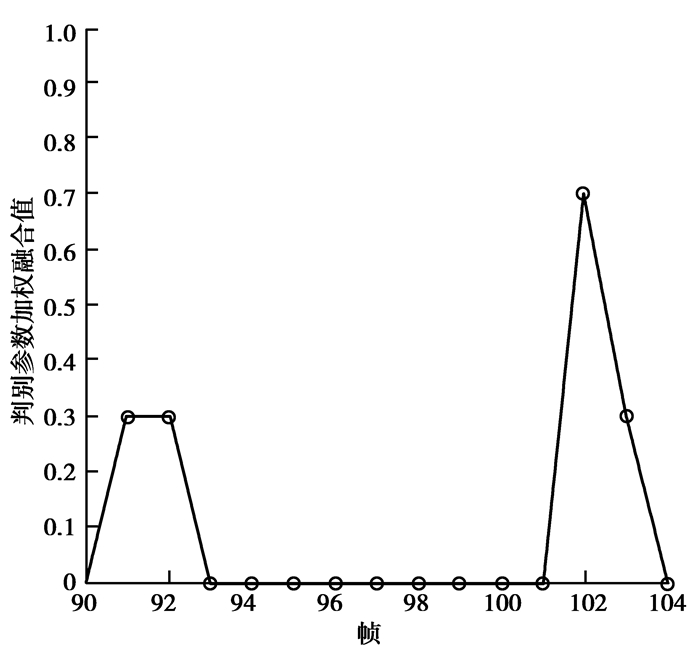

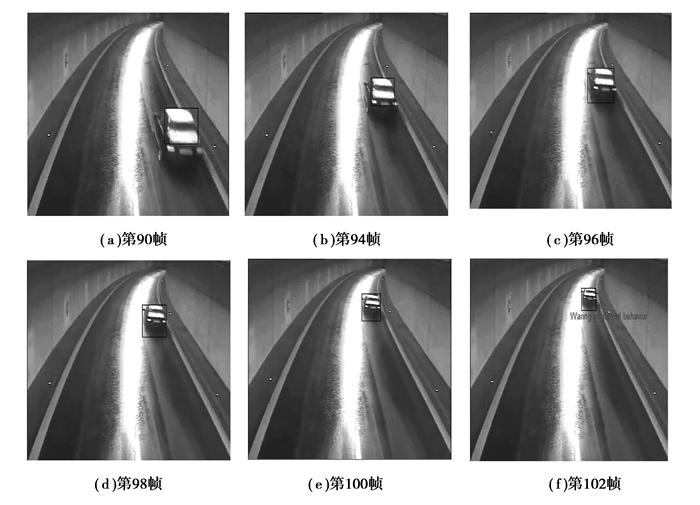

通过观察检测视频2可知,视频中车辆在隧道行驶过程中突然停车,此行为在该场景下属于异常行为。视频中该车的车辆位置改变量、车辆速度改变量、车辆运动方向改变量结果图分别如图 10、图 11、图 12所示。通过对该场景中大量正常行驶车辆的数据分析与验证,取车辆位置改变量阈值Tp=10、车辆速度改变量阈值Ta=8、车辆运动方向改变量阈值Tθ=1。通过反复实验分析,分别取车辆位置改变量、车辆速度改变量、车辆运动方向改变量状态函数的加权系α=0.2,β=0.5,γ=0.3,车辆异常行为判别阈值T=0.5。车辆行为判别参数状态函数的加权融合结果如图 13所示。实际视频场景中车辆异常行为检测结果如图 14所示。检测视频中第90帧出现车辆,在第102帧图像中检测出车辆出现隧道内突然停车的异常行为,视频图像中出现红色警示信息。车辆从第102帧开始停止运动。

|

图10 车辆速度改变图Tp=10 Fig. 10 The change of vehicle position Tp=10 |

|

图11 车辆速度改变图Ta=6 Fig. 11 The change of vehicle velocity Ta=6 |

|

图12 车辆运动方向改变图Tθ=0.8 Fig. 12 The change of vehicle moving direction Tθ=0.8 |

|

图13 车辆异常行为判别参数状态函数加权融合结果图α=0.2,β=0.5,γ=0.3,T=0.5 Fig. 13 Weighted fusion result of vehicle abnormal behavior discrimination parameters α=0.5,β=0.35,γ=0.15,T=0.7 |

|

图14 车辆异常行为检测过程 Fig. 14 The process of vehicle abnormal behavior detection |

针对当前车辆异常行为检测中存在的检测实时性问题,提出了一种基于智能视频分析的车辆异常行为检测方法。通过背景差分法检测运动车辆,结合均值漂移算法进行车辆跟踪,并提取出车辆异常行为判别参数,运用多参数加权融合方法,检测车辆异常行为。为验证算法的有效性,对真实场景的监控视频进行了仿真实验,实验结果表明采用的算法能及时有效地检测出车辆的异常行为。

| [1] | 王会.基于视频的车辆异常行为检测[D].沈阳:沈阳工业大学,2013. WANG Hui. Vehicle abnormal behavior detection system based on vedio[D]. Shenyang:Shenyang University of Technology, 2013. (in Chinese)( 1) 1) |

| [2] | 王树欣,伍湘彬.地感线圈在交通控制领域中的应用[J].电子世界,2005,(8):47. WANG Shuxin, WU Xiangbin. Application of sense coil in traffic control field[J]. Electronics World, 2005(8):47. (in Chinese)( 1) 1) |

| [3] | 邵士雨.基于视频的交通事件检测算法研究[D].济南:山东大学,2013. SHAO Shiyu. Research on algorithm for traffic incident recognition based on video[D]. Jinan:Shandong University, 2013. (in Chinese)( 1) 1) |

| [4] | Saini M. Survey on vision based on road vehicle detection[J]. International Journal of U-& E-Service, Science & Technology, 2014, 7(4):139.( 1) 1) |

| [5] | Lan J, Jiang Y, Fan G, et al. Real-time automatic obstacle detection method for traffic surveillance in urban traffic[J]. Journal of Signal Processing Systems, 2016, 82(3):357-371.( 1) 1) |

| [6] | Kimachi M, Kanayama K, Teramoto K. Incident prediction by fuzzy image sequence analysis[C]//Proceeding of Vehicle Navigation and Information Systems Conference, 1994. Aug 31-Sep 2, 1994. Yokohama:IEEE, 1994:51-56.( 1) 1) |

| [7] | 叶荣炬,李振龙,陈阳舟,等.一种基于车辆时空图的车辆异常行为检测方法[J].交通信息与安全,2012,30(4):89-92+98. YE Rongju, LI Zhenlong, CHEN Yangzhou, et al. A detection method for abnormal vehicle behavior based on space time diagram[J]. Computer and Communications, 2012, 30(4):89-92. (in Chinese)( 1) 1) |

| [8] | 庞成俊.基于全景视觉的车辆异常行为检测技术的研究[D].杭州:浙江工业大学,2009. PANG Chengjun. Research of vehicle abnormal behavior detection technology based on omni-directional vision[D]. Hangzhou:Zhejiang University of Technology, 2009. (in Chinese)( 1) 1) |

| [9] | 彭银香,朱志勇.基于视频的车辆碰撞事件预测算法研究[J].微计算机信息,2007,23(6):19-20. PENG Yinxiang, ZHU Zhiyong. Study on vehicle accident prediction based video[J]. Control & Management, 2007, 23(6):19-20. (in Chinese)( 1) 1) |

| [10] | 拜佩,李金屏.一种基于视频的交通事故检测方法[J].济南大学学报(自然科学版),2012,26(3):282-286. BAI Pei, LI Jinping. A video-based method of traffic accident detection[J]. Journal of University of Jinan (Science and Technogoly), 2012, 26(3):282-286. (in Chinese)( 1) 1) |

| [11] | 王亚飞.视频图象运动目标检测与跟踪方法研究[D].重庆:重庆大学,2009. WANG Yafei. A method of moving objects detection and tracking for video image[D]. Chongqing:Chongqing University, 2009. (in Chinese)( 1) 1) |

| [12] | 王宏义.基于视频图像的交通事件检测系统研究与开发[J].公路与汽运,2007,(3):57-60. WANG Hongyi. Research on the development of traffic incident detection system based on video[J]. Highways & Automotive Applications, 2007, (3):57-60. (in Chinese)( 1) 1) |

| [13] | Morris B T, Trivedi M M. A survey of vision-based trajectory learning and analysis for surveillance[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2008, 18(8):1114-1127.( 1) 1) |

| [14] | Hui Z, Xie Y, Lu M, et al. Vision-based real-time traffic accident detection[C] //2014 11th World Congress on Intelligent Control and Automation (WCICA). June 29-July 4, 2014.Shenyang:IEEE, 2015:1035-1038.( 1) 1) |

| [15] | 董春利,董育宁. 基于视频的车辆检测与跟踪算法综述[J].南京邮电大学学报(自然科学版),2009,29(2):88-94. DONG Chunli, DONG Yuning. Survey on video based vehicle detection and tracking algorithm[J]. Journal of Nanjing University of Posts and Telecommunications (Natural Science), 2009, 29(2):88-94. (in Chinese)( 1) 1) |

2016, Vol. 39

2016, Vol. 39