2. 恩波利亚州立大学商学院, 堪萨斯 美国

2. School of Business, Emporia State University, Kansas, the United States

随着科研工作的不断深入以及信息技术的高速发展,越来越多的科研相关知识成果被研究者发布在网络上,以便查阅。科研人员经常需要查找感兴趣的技术资料,如何迅速地从广袤浩如烟海的数据中获取需要的条目,是迫切需要解决的问题。知识推荐算法可以对传统的搜索引擎加以优化,近年来活跃在诸多领域中。然而,现有的知识推荐方法仍存在一些不足,其中最主要的问题是:现有方法大多仅考虑知识的单一模态特征,忽视了不同模态特征之间的互补性优势;同时,为所有的数据赋予相同的权重,其中弱相关性的信息影响了提取特征的质量,导致最终的推荐效果不理想。

雷达(radar)是运用无线电定位方法进行探测识别,测定目标坐标或其他情报的装置。在现代军事和生产中,其重要性与日俱增,雷达相关研究产生的知识成果也受到了相关学者的广泛关注。但是,由于雷达知识的数量越来越多,且不同领域的雷达知识专业性较强,科研人员很难快速准确地查找到自己感兴趣的雷达技术资料。因此,通过应用并改进知识推荐算法,从海量的雷达知识中挖掘重要信息,协助检索已有的雷达知识成果,可以有效提高科研人员的学习和工作效率,帮助科研人员快速准确地查找到自己感兴趣的雷达知识,协助科研人员进行雷达相关的研究和技术产品设计。因此,进行雷达知识推荐的相关研究具有重要意义和应用前景。

综上所述,针对现有知识推荐方法存在的问题,文中提出了一种基于注意力模型的多模态特征融合的知识推荐方法,并应用其解决雷达知识成果推荐的实际问题。该方法的核心是通过注意力模型提升特征向量的性能,并且利用多模态特征之间优势互补的特性,提取知识的多模态特征,学习一种高层次的融合特征表示。分别提取雷达知识的词向量特征(Word2vec)特征和词频-逆文档率特征(TF-IDF, term frequency-inverse document frequency),并将雷达知识的Word2vec特征输入到注意力模型中,得到Word2vec特征经过处理后的特征向量。为了实现多模态特征的融合,还设计了一种基于深度神经网络的多模态深度融合方法,结合分类交叉熵损失学习多模态特征的高阶融合特征。在雷达知识推荐阶段,采用所学习的雷达知识的融合特征计算相似度,将相似度最高的N个(Top-N)推荐给用户。通过从中国知网收集雷达知识数据并设计模拟实验,验证了提出方法的有效性。实验结果表明,与使用单一模态特征进行推荐相比,文中提出的基于注意力模型的多模态特征融合方法可以有效提高雷达知识推荐的性能。

1 相关工作 1.1 多模态特征融合在基于深度神经网络的数据分析任务中,首先需要对数据的关键特征进行提取。由于可获取的信息广袤、来源多样,数据往往呈现多模态的特性:对于同一个对象,可通过不同领域或视角对其进行描述,从而得到一系列数据[1]。为了对此类多模态数据进行有效地处理,现有策略通常选择不同模态的数据分别建立模型,而后在决策时加以融合[2]。由于中文文本的特殊性和表义的复杂性,需要使用针对性的手段,处理更加困难。文献[3]基于有监督的机器学习算法,提出基于多文本特征融合的中文微博立场检测方法;文献[4]串联了Word2vec和BLSM分别生成的词向量,提出一种基于特征融合的中文简历解析方法。文献[5]则提出了一种改进的典型相关性分析方法,有效地完成多模态数据特征提取。以上方法在针对中文文本的多模态数据特征提取和融合方面虽然取得了一定的进展,但是仍然存在一些问题值得探索,如:为数据赋予相同权重,缺乏对数据的贡献进行评估,难以在过程中过滤与任务相关性弱的信息等。而在雷达知识推荐领域,方法尚未得到充分的推广和应用。现有研究中,尚未有应用深度神经网络,根据输入的中文关键字推荐对应知识的有效方案。

1.2 知识推荐在知识推荐过程中,以个性化的方法提供引导,并从大量潜在候选项中找到用户可能感兴趣或有用的信息作为输出结果,该过程与为目标用户提供雷达知识的任务是一致的。目前,知识推荐的算法实现大致可以分为基于内容的推荐方法、协同过滤方法、混合推荐方法等[6],此外,人工智能、深度神经网络等先进思想也更多地应用于推荐算法的改进中。文献[7]从专利文本的标题和摘要入手,提出一种基于文本挖掘的专利推荐方法。文献[8]针对科研社交网络对科研人员的论文推荐问题,提出了一种融合科研人员标签的论文推荐方法RTOC-CF。文献[9]开发了一个跨平台的项目推荐系统paper2repo,它可以自动推荐GitHub上与学术搜索系统中指定论文匹配的知识库。文献[10]提出了一个统一的电子评论模型。目前,针对不同类型的知识,研究者已经在诸多领域开展了知识推荐的相关研究,但其中只有少数借助了深度方法,考虑多模态数据特点的方法更少。在文中,将注意力机制引入知识推荐过程中,在使用深度神经网络进行高效特征提取的同时,对任务中的无关信息进行过滤,提高推荐效率,并针对科研人员查找与自己研究方向相关的雷达技术资料的需求,实现基于注意力机制的雷达知识推荐模型。

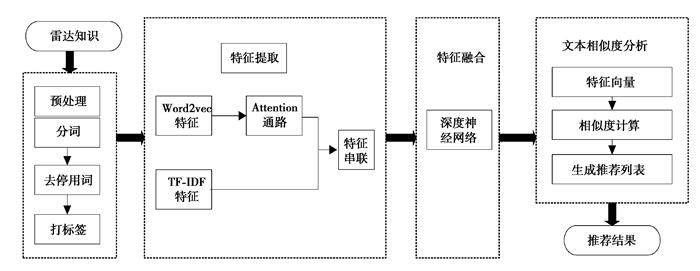

2 基于注意力机制的雷达知识推荐模型如图 1所示为文中所提出方法的总体流程。文中提出的基于注意力模型的雷达知识推荐模型主要包括数据预处理、多模态特征提取、多模态特征融合和雷达知识推荐4个阶段。

|

图 1 雷达知识推荐流程 Fig. 1 The process of radar knowledge recommendation |

文中收集的雷达知识源数据属于半结构化数据,需要通过数据预处理,将源数据转化为可以输入模型的形式。数据预处理主要包括以下两个步骤:

1) 分词:中文文本的字词之间没有空格分隔,字与词之间的区分十分依赖语义与语境。所以,首先需要对雷达知识的原始语料进行分词操作,使用jieba分词工具完成分词操作。

2) 去停用词:使用哈工大停用词表,去除分词之后的语料中包含的没有实际意义的部分。

2.2 注意力模型注意力机制最早出现在视觉图像领域[11],旨在关注视觉或文本输入的某些相关部分,这有助于学习更具辨别力的表征[12]。通过在模型中引入注意力机制,可以过滤掉大量与任务无关的信息。文中为了提高从雷达知识源数据中提取的特征向量的代表性,首先将提取到的特征向量输入到注意力模型中进行处理。

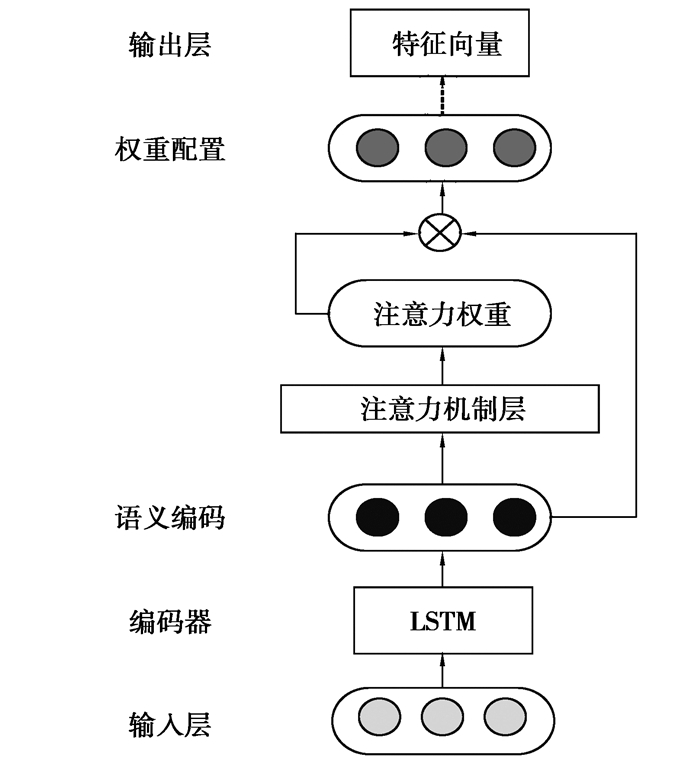

文中使用的注意力模型由输入层、LSTM层、注意力机制层和输出层组成,模型结构如图 2所示。注意力模型的工作过程为:1) 将提取的雷达知识的Word2vec特征向量作为模型的输入层;2) 使用LSTM作为编码器,对输入的文本特征向量进行编码,获得文本的语义编码;3) 将语义编码输入到注意力机制层,放大重要特征的权重,得到整个网络的权重分配,充分挖掘文本的深层语义信息,得到表征能力更强的文本表示向量[13];4) 将注意力权重与潜在语义表示进行加权平均,得到最终的文本表示。

|

图 2 注意力模型流程图 Fig. 2 The flow chart of attentional model |

文中提出的多模态特征提取主要分为如下3个阶段:

1) 提取并通过注意力模型处理雷达知识的Word2vec特征。

Word2vec是目前被广泛应用于自然语言处理(NLP,natural language processing)领域的一款词向量计算工具[14]。文中提取雷达知识的Word2vec特征向量的原理是:将经过数据预处理后的雷达知识数据输入到模型中,获得雷达知识数据中所有词语的向量表示,再对一个雷达知识中所有的词向量求平均,最终得到150维的雷达知识的Word2vec的特征向量:Vw=(vw1, vw2, ..., vw150)。

将得到的Word2vec特征输入到注意力模型当中,得到最终的文本表示。Word2vec特征经过注意力模型处理过后,得到128维的特征向量:Vwatt=(va1, va2, ..., va128)。

2) 提取雷达知识的基于词频的特征权重(TF-IDF)算法特征。

TF-IDF是一种统计方法,可以有效评估特定字词对于一个文本集或一个语料库的重要程度。其中,词频TF指的是某一个给定的词语W在该文件中出现的次数:

| $ F_{\mathrm{TF}}=\frac{W}{N_{\text {words }}}。$ | (1) |

在逆向文件频率IDF中,使用语料库的文档总数与包含该词的文档数进行比较:如果包含词条的文档越少, 则IDF越大,说明词条具有很好的类别区分能力:

| $ F_{\mathrm{IDF}}=\log \frac{N_{\text {Documents }}}{N_{\mathrm{wDocuments}}+1}。$ | (2) |

词频-逆文档频率TF-IDF值与该词的出现频率成正比,与在整个语料库中的出现次数成反比:

| $ F_{\mathrm{TF}}-F_{\mathrm{IDF}}=F_{\mathrm{TF}} * F_{\mathrm{IDF}} \text { 。} $ | (3) |

使用Python的sklearn库提取雷达知识的TF-IDF特征向量。最终得到的TF-IDF特征向量可以表示为Vt=(vt1, vt2, ..., vt500)。

3) 多模态特征串联。

现有的利用文本多模态特征的方法中,有许多是直接使用文本多模态特征的串联特征。文中将提取的Word2vec特征经过注意力模型处理后,得到特征向量,再与TF-IDF特征进行拼接。得到的串联后的特征向量可表示为:V′=(va1, va2, ..., va128, vt1, vt2, ..., vt500)。

2.4 多模态特征融合尽管使用多模态特征的串联特征可以在一定程度上提高知识推荐的性能,但是直接使用串联特征会大大增加特征向量的维度,容易造成维度灾难问题,从而增加雷达知识推荐任务的时间复杂度。因此,需要对雷达知识的多模态特征进行有效融合,从而既减少融合后特征的维度,又能充分利用雷达知识不同模态特征的互补特性。

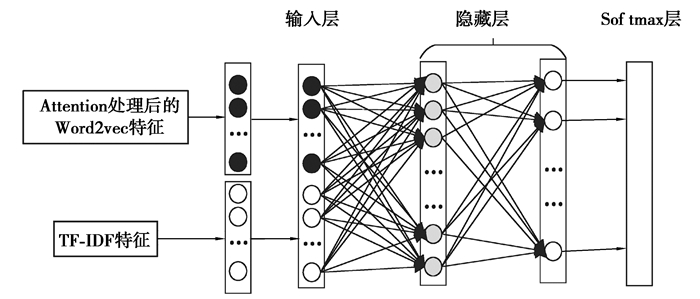

为了实现多模态特征融合,提出了一种基于深度神经网络的多模态特征融合方法,结合分类交叉熵损失学习多模态特征的高阶融合特征,具体的网络结构如图 3所示。其中,多层神经网络负责融合多模态特征,softmax层则用于度量分类损失,从而评价多模态融合特征的性能。网络的输入为雷达知识经过注意力模型处理之后的Word2vec特征和TF-IDF特征的串联特征。在网络的隐藏层中,使用2个全连接层,用于学习雷达知识的高阶特征,进行多模态特征融合。通过softmax层的输出计算分类损失,使损失函数最小化,提高融合后特征的分类精度。最终输出适用于目标任务的雷达知识的高阶融合特征。

|

图 3 深度神经网络结构 Fig. 3 Structure of deep neural network |

文中提出的深度神经网络的损失函数由两部分组成。第一部分为交叉熵损失:

| $ L_{1}=-\sum\limits_{i} y_{i} \log \left(p_{i}\right), $ | (4) |

式中:yi为雷达知识的实际类别;pi为softmax判别器输出的类别。

除此之外,还考虑了不同模态之间的相似度保持,在损失函数中引入了拉普拉斯图正则化项:

| $ L_{2}=\operatorname{tr}\left(\boldsymbol{y}^{\mathrm{T}} \boldsymbol{L} \boldsymbol{y}\right), $ | (5) |

式中:L=D-S,S由标签信息计算得来,S=yyT,D是一个对角阵,D的对角元为S的列和

综上所述,深度神经网络的损失函数为

| $ \operatorname{Loss}=L_{1}+\alpha L_{2}, $ | (6) |

式中,α为图正则化项的系数。雷达知识经过多模态特征融合后为256维的特征向量:V=(v1, v2, ..., v256)。

2.5 雷达知识推荐在雷达知识推荐阶段,经过对雷达知识进行相似度计算,生成推荐列表,从而完成为使用者推荐相应知识的目标。文中通过计算余弦相似度来评估两个雷达知识数据之间的相似度,计算公式为

| $ \operatorname{sim}(a, b)=\frac{\sum\limits_{i=1}^{256}\left(v_{a i} * v_{b i}\right)}{\sqrt{\sum\limits_{i=1}^{256}\left(v_{a i}\right)^{2} * \sqrt{\sum\limits_{i=1}^{256}\left(v_{b i}\right)^{2}}}}, $ | (7) |

式中:sim(a, b)表示雷达知识数据a和b之间的相似度;vai表示雷达知识数据a的第i个特征;vbi表示雷达知识数据b的第i个特征。sim(a, b)的值越大,说明两个雷达知识数据的相似度越大。

3 实验分析 3.1 数据获取目前尚无适用于雷达知识推荐的公开数据集。因此,文中首先自行完成实验数据集的采集和构建工作。数据的主要来源是中国知网,通过知网查询并导出雷达知识相关成果的摘要信息。文中共收集了7种类别的雷达知识数据。首先,对雷达知识数据进行清洗操作;然后,按照6∶2 ∶2的比例将数据分为训练集、验证集和测试集;最后,为数据进行标签标注。文中构建的雷达知识数据集的具体信息如表 1所示。

| 表 1 数据集属性 Table 1 Properties of data set |

为了验证文中提出的基于注意力模型的多模态特征融合的雷达知识推荐算方法的有效性,并比较提出的基于注意力模型的多模态特征融合的雷达知识推荐方法的性能,共设置了4种基准算法用于比较:

1) 使用雷达知识的Word2vec特征进行雷达知识推荐。

2) 使用雷达知识的Word2vec特征经过注意力模型处理后得到的特征向量进行雷达知识推荐。

3) 使用雷达知识的TF-IDF特征进行雷达知识推荐。

4) 使用雷达知识的Word2vec特征经过注意力模型处理后得到的特征向量和TF-IDF特征的串联特征进行雷达知识推荐。

在模型训练过程中,对超参数进行优化。经过大量的实验,笔者得到了以下模型的最佳参数:提取的雷达知识的Word2vec特征和TF-IDF特征的维数分别为150维和500维,将Word2vec特征向量输入到注意力模型后,得到128维的特征向量。用于多模态特征融合的深度神经网络的全连接层的层数设置为2层,神经元个数分别为1 024和512,深度神经网络的输入为628维的雷达知识的串联特征。此外,在训练的过程中,把学习率ρ设置为0.001,正则化项系数α设置为0.005,为用户推荐的雷达知识的个数N设置为10、30、50,若输入的雷达知识信息和推荐的雷达知识属于相同类别,则认为推荐结果正确。

3.3 评价指标与其他的推荐算法不同,雷达知识推荐仅依赖于当前用户输入的雷达知识的信息,不需要考虑用户的历史操作信息,所以推荐算法的常用评价指标并不适用于雷达知识推荐。因此,文中使用准确率Precision(APrecision)、召回率Recall(ARecall)和F1值(根据准确率和召回率二者给出的一个综合的评价指标)作为评估雷达知识推荐结果的评价指标。

相关的计算公式如下:

| $ A_{\text {Precision }}=\frac{n_{\text {correct }}}{N}, $ | (8) |

| $ A_{\text {Recall }}=\frac{n_{\text {correct }}}{n_{{\text {object }}i}}, $ | (9) |

| $ F_{1}=\frac{2 * A_{\text {Precision }} * A_{\text {Recall }}}{A_{\text {Precision }}+A_{\text {Recall }}}, $ | (10) |

| $ \operatorname{mean} F_{1}=\frac{1}{n_{\text {total }}} \sum\limits_{i=1}^{n_{\text {total }}} F_{1}^{i}, $ | (11) |

式中:ncorrect代表推荐给用户的推荐列表中和输入的雷达知识属于同一类的结果个数;N代表向用户推荐的雷达知识个数;nobjecti代表数据库中第i类雷达知识数据的总数;ntotal代表测试集中所有类别的雷达知识数据总数。首先分别求出测试集中每一个雷达知识推荐的F1值,最后求出测试集中所有雷达知识推荐的F1值的平均值meanF1作为最终推荐任务的总体F1值,如式(11)所示。

3.4 实验结果分析表 2为不同方法在推荐个数N分别为10、30、50时,雷达知识推荐的实验结果。由表 2的实验结果可以看出,使用雷达知识的Word2vec特征经过注意力模型处理过后的特征(w2v_att)进行雷达知识推荐的准确率、召回率和F1值均明显好于使用Word2vec特征(w2v)进行雷达知识推荐的结果,说明注意力模型可以显著提高特征向量的性能。使用雷达知识的融合特征(w2v_att&tfidf)进行雷达知识推荐的准确率明显高于使用其他特征的推荐结果。此外,使用直接串联特征(w2v_att+tfidf)的雷达知识推荐的结果远远好于使用单模态TF-IDF特征推荐(tfidf),说明多模态特征表现要好于单一模态特征。但是,使用串联特征(w2v_att+tfidf)的雷达知识推荐的结果与使用单一模态Word2vec特征经过注意力模型处理过后的特征推荐(w2v_att)结果相比,提升不大,由此可见,不能简单地将多模态特征进行直接串联。不仅如此,从表中还能看出,使用单一特征和串联特征的雷达知识推荐的结果随着推荐个数的增加而减小,而使用文中方法学习的多模态融合特征推荐的结果较为稳定而且呈现平稳上升的趋势,这进一步说明了所提出的方法在融合多模态特征优势互补方面的有效性。

| 表 2 雷达知识推荐实验结果 Table 2 Experimental results of radar knowledge recommendation |

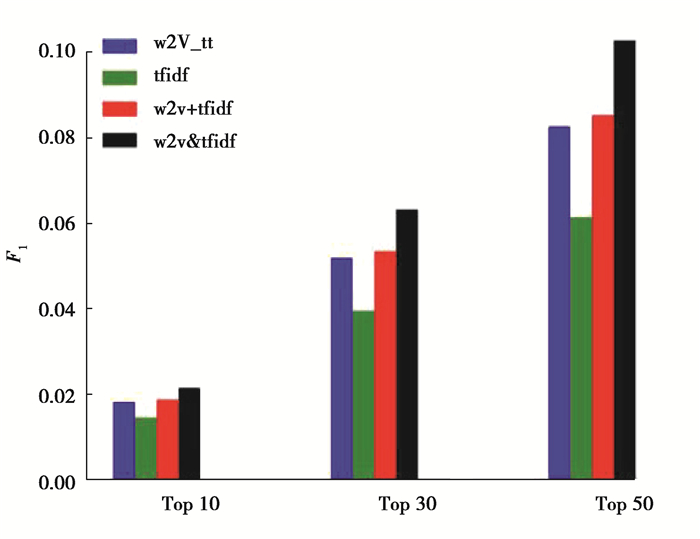

如图 4所示,对4种不同方法的雷达知识推荐结果的F1值结果进行了对比。

|

图 4 F1值结果对比 Fig. 4 Comparison of F1 value results |

根据实验结果可以发现,使用雷达知识的融合特征进行雷达知识推荐的F1值明显高于使用其他特征推荐的F1值,这说明了文中算法的有效性。此外,雷达知识推荐的F1值随着推荐个数N的增加而提高,总体呈现上升趋势。另外,使用文中方法学习的多模态融合特征进行雷达知识推荐的F1值的增加幅度,明显大于使用其他3种特征推荐结果F1值的增加幅度,这进一步说明了文中方法在雷达知识推荐方面的优越性。

结合上述结果分析,只使用雷达知识的单模态TF-IDF特征进行雷达知识推荐的效果最差,推荐的准确率只有50%左右。使用雷达知识的Word2vec特征经过注意力模型处理过后的特征(w2v_att)进行雷达知识推荐的性能明显好于使用Word2vec特征(w2v)进行雷达知识推荐的结果,说明使用注意力模型对于提高雷达知识的特征向量的性能是有效的。直接使用串联特征(w2v_att+tfidf)的雷达知识推荐的准确率远远高于单模态TF-IDF特征推荐(tfidf),但与使用单一模态Word2vec特征经过注意力模型处理过后的特征推荐(w2v_att)准确率相比提升不大,说明多模态特征表现通常能好于单一模态特征,但不能只进行简单的串联。总体来看,文中提出的基于注意力模型的多模态特征融合方法的雷达知识推荐结果明显优于使用另外4种特征表示的推荐结果,准确率可以达到76%,召回率和综合评价指标F1的值也明显高于其他4种方法。结果表明,使用Word2vec特征经过注意力模型处理过后的特征和TF-IDF特征进行多模态特征融合,学习高层次融合特征,能够更加全面地体现雷达知识中的信息,有效提升雷达知识推荐的效果。

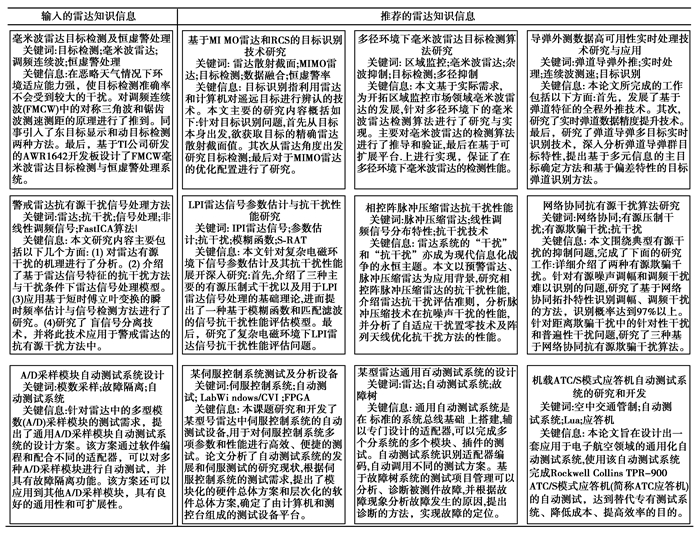

3.5 雷达知识推荐案例分析笔者从数据库中随机抽取了3个不同类型的雷达知识数据进行雷达知识推荐,案例分析结果如图 5所示。从图中可以看出,推荐的雷达知识与输入的雷达知识信息的类别相同,并且推荐的雷达知识的与输入的雷达知识信息具有相同的关键词和相似的关键信息,说明使用文中提出的雷达知识推荐方法的推荐结果是比较准确的,可以为相关的科研人员提供较为全面的参考。结果表明,基于注意力模型的多模态特征融合的雷达知识推荐方法可以全面的利用雷达知识多模态特征信息,体现了文中提出方法的优越性。

|

图 5 雷达知识推荐案例分析 Fig. 5 Case study of radar knowledge recommendation |

针对现有知识推荐方法的不足,本文提出了一种基于注意力模型的多模态特征融合知识推荐算法,并将其应用于雷达知识推荐任务中。通过在模型中引入注意力机制,提高雷达知识特征向量的性能,同时充分利用雷达知识不同模态特征表示的优势,学习高层次的雷达知识多模态融合特征表示,进而实现雷达知识推荐。实验结果表明,通过注意力模型可以有效的提升雷达知识的特征向量的性能,此外,相比只用单一模态特征以及简单串联特征进行的雷达知识推荐,使用多模态特征融合后的特征进行雷达知识推荐的结果有了明显的提高。这说明本文提出的方法不仅可以有效提高特征向量的性能,还能够融合雷达知识的多模态特征,使推荐结果更加准确,能够有效提高相关科研人员的学习和工作效率,具有重要意义和应用前景。

| [1] |

Lahat D, Adlt T, Jutten C. Multimodal data fusion: An overview of methods, challenges, and prospects[J]. Proceedings of the IEEE, 2015, 103(9): 1449-1447. DOI:10.1109/JPROC.2015.2460697 |

| [2] |

赵磊. 基于深度学习的多模态数据特征提取与选择方法研究[D]. 天津: 天津大学, 2016. Zhao L. Feature extraction and selection from multi-modality data based on deep learning[D]. Tianjin: Tianjin University, 2016. (in Chinese) |

| [3] |

奠雨洁, 金琴, 吴慧敏. 基于多文本特征融合的中文微博的立场检测[J]. 计算机工程与应用, 2017, 53(21): 77-84. Dian Y J, Jin Q, Wu H M. Stance detection in Chinese microblogs via fusing multiple text features[J]. Computer Engineering and Applications, 2017, 53(21): 77-84. (in Chinese) DOI:10.3778/j.issn.1002-8331.1702-0292 |

| [4] |

陈毅, 符磊, 代云霞, 等. 基于特征融合的中文简历解析方法研究[J]. 计算机工程与应用, 2019, 55(10): 244-249. Chen Y, Fu L, Dai Y X, et al. Research of Chinese resume analysis based on feature fusion[J]. Computer Engineering and Applications, 2019, 55(10): 244-249. (in Chinese) DOI:10.3778/j.issn.1002-8331.1803-0142 |

| [5] |

Yuan Y, Sun Q. Multiset canonical correlations using globality preserving projections with applications to feature extraction and recognition[J]. IEEE Transactions on Neural Networks and Learning Systems, 2014, 25(6): 1131-1146. DOI:10.1109/TNNLS.2013.2288062 |

| [6] |

Feng C, Khan M, Rahman A U, et al. News recommendation systems-accomplishments, challenges & future directions[J]. IEEE Access, 2020, 8(1): 16702-16725. |

| [7] |

艾楚涵, 姜迪, 吴建德. 基于主题模型和文本相似度计算的专利推荐研究[J]. 信息技术, 2020, 44(4): 65-70. Ai C H, Jiang D, Wu J D. Patent recommendation research based on topic model and text similarity calculation[J]. Information Technology, 2020, 44(4): 65-70. (in Chinese) |

| [8] |

吴磊, 岳峰, 王含茹, 等. 一种融合科研人员标签的学术论文推荐方法[J]. 计算机科学, 2020, 47(2): 51-57. Wu L, Yue F, Wang H R, et al. Academic paper recommendation method combined with research tag[J]. Computer Science, 2020, 47(2): 51-57. (in Chinese) |

| [9] |

Shao H, Sun D, Wu J, et al. Paper2repo: github repository recommendation for academic papers[C]. Proceedings of The Web Conference 2020. 2020: 629-639.

|

| [10] |

Li S, Brusilovsky P, Su S, et al. Conference paper recommendation for academic conferences[J]. IEEE Access, 2018, 6: 17153-17164. DOI:10.1109/ACCESS.2018.2817497 |

| [11] |

Ji Z, Lin Z, Wang H, et al. Multi-modal memory enhancement attention network for image-text matching[J]. IEEE Access, 2020, 8: 38438-39447. DOI:10.1109/ACCESS.2020.2975594 |

| [12] |

黄露, 周恩国, 李岱峰. 融合特定任务信息注意力机制的文本表示学习模型[J/OL]. 数据分析与知识发现: 1-23[2020-06-10]. http://manu44.magtech.com.cn/Jwk_infotech_wk3/CN/10.11925/infotech.2096-3467.2020.0204. Huang L, Zhou E G, Li D F. Fusion of task-specific information based attention mechanism for text representation learning model[J/OL]. Data Analysis and Knowledge Discovery: 1-23[2020-06-10]. http://manu44.magtech.com.cn/Jwk_infotech_wk3/CN/10.11925/infotech.2096-3467.2020.0204. (in Chinese) |

| [13] |

王娜, 何晓明, 刘志强, 等. 一种基于用户播放行为序列的个性化视频推荐策略[J]. 计算机学报, 2020, 43(1): 123-135. Wang N, Huang X M, Liu Z Q, et al. Personalized video recommendation strategy bases on user's playback behavior sequence[J]. Chinese Journal of Computer, 2020, 43(1): 123-135. (in Chinese) |

| [14] |

春妮, 冯朝胜. 结合句法特征和卷积神经网络的多意图识别模型[J]. 计算机应用, 2018, 38(7): 1839-1845, 1852. Chun N, Feng C S. Multi-intention recognition model with combination of syntactic feature and convolution neural network[J]. Journal of Computer Applications, 2018, 38(7): 1839-1845, 1852. (in Chinese) |

2021, Vol. 44

2021, Vol. 44